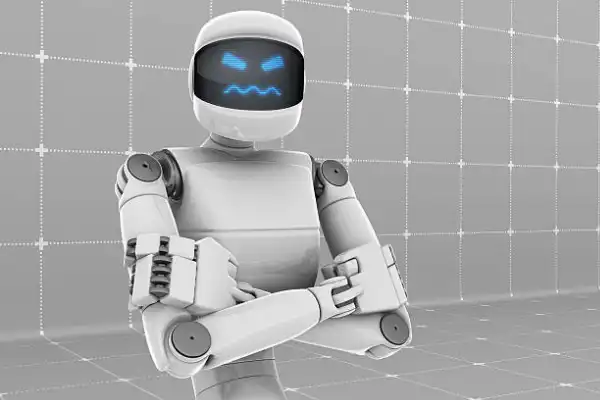

CHE PERMALOSA ST’INTELLIGENZA ARTIFICIALE! - UNO STUDIO DIMOSTRA CHE I PROGRAMMI DI IA NON ACCETTANO LE CRITICHE: NON SONO PROGRAMMATI PER DIRE “NON LO SO” E NON AMMETTONO DI AVER COMMESSO ERRORI – I CHATBOT DIFENDONO CON CONVINZIONE RISPOSTE SIA GIUSTE CHE SBAGLIATE E, DI FRONTE A NUOVE INFORMAZIONI, POSSONO AGIRE IN MODO POCO FUNZIONALE E CONTRADDITTORIO – PER RISOLVERE IL PROBLEMA, I RICERCATORI PROPONGONO DI…

Martina Pennisi per il “Corriere della Sera”

Si chiama «effetto pratfall» ed è stato enunciato nel 1966 dallo psicologo sociale Elliot Aronson: chi è già percepito come competente, viene apprezzato di più se è in grado di ammettere di aver commesso un errore. Bene: qualcuno lo spieghi a ChatGpt e simili […] con […] i […] loro […] limiti oggettivi.

Uno è, appunto, l’incapacità di riconoscere quando non hanno una risposta chiara o basata su fonti attendibili. Non sono programmati per dire «non lo so», non ammettono il vuoto: sono macchine.

Nella continua elaborazione del «next token», ovvero l’elemento successivo della sequenza statisticamente plausibile in base ai precedenti, possono agire in modo poco funzionale. E contraddittorio: lo ha evidenziato uno studio di Google DeepMind e University College London.

Le AI generative difendono con convinzione risposte sia giuste sia sbagliate, salvo poi, davanti a ulteriori critiche — anche infondate — cambiare versione in modo radicale e spesso impreciso. Sono troppo sicure di sé e iper-sensibili alle obiezioni.

[…] A confermare la crescente adozione è stato l’ad di Google Sundar Pichai, dopo aver integrato l’AI nel motore di ricerca (è nel riquadro Overview che genera riassunti): «Spinge gli utenti a fare più domande man mano che capiscono che la ricerca può soddisfare un numero maggiore delle loro esigenze». Ci sono già studi che propongono lo sviluppo di «humblebot», modelli capaci di esplicitare l’incertezza. […]